Accueil > 01 - Livre Un : PHILOSOPHIE > L’image du chaos déterministe > La théorie du chaos déterministe

La théorie du chaos déterministe

lundi 3 mai 2010, par , ,

Chaos et imprédictibilité, le film

LA "SENSIBILITÉ AUX CONDITIONS INITIALES" SIGNIFIE QUE LES LOIS NE PERMETTENT PAS DE PRÉDIRE PARCE QU’UN TOUT PETIT CHANGEMENT DES VALEURS DE DÉPART ENTRAINE UN AVENIR TRÈS DIFFÉRENT

Site : Matière et révolution

MOTS CLEFS :

dialectique –

discontinuité –

physique quantique – relativité –

chaos déterministe – atome –

système dynamique – percolation –

non-linéarité –

émergence –

inhibition –

boucle de rétroaction – rupture de symétrie –

le temps -

contradictions –

crise –

transition de phase – criticalité - attracteur étrange –

auto-organisation – vide - révolution permanente - Zénon d’Elée -

Blanqui -

Lénine -

Trotsky – Rosa Luxemburg –

Prigogine -

Barta -

Gould - marxisme - Marx - la révolution - l’anarchisme - le stalinisme

Pour nous écrire, cliquez sur Répondre à cet article

Sur le même thème, lire sur le site Matière et Révolution :

Le chaos déterministe

Le cœur et le chaos

Le cerveau et le chaos

Psychanalyse et chaos déterministe

Climatologie et chaos déterministe.

Peut-on prédire l’évolution ou les révolutions du climat ? Les discontinuités, les rétroactions et les non-linéarités, la dynamique chaotique de la géophysique et de la climatologie.

Qu’est-ce que le chaos déterministe en sciences ?

Lire à l’extérieur du site :

James Gleick expose le chaos déterministe

Poincaré invente le chaos déterministe

– - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

« Des systèmes dynamiques ne commencent à présenter des comportements complexes et chaotiques que lorsque leur trajectoire a lieu dans les trois dimensions. Ce n’est qu’alors qu’elles peuvent prendre des formes compliquées en s’enroulant les unes autour des autres sans se couper. »

Le physicien John D Barrow

dans « Les constantes de la nature »

Qu’est-ce que le chaos déterministe ? L’astrophysicien John Barrow l’explique dans « La grande théorie » : « Une brisure de symétrie particulière, connue sous le vocable « chaos », présente de nos jours un intérêt bien plus considérable que prévu. L’évolution des phénomènes chaotiques montre une extrême sensibilité à l’état initial. La plus légère modification de l’état de départ conduit à d’énormes différences dans les états ultérieurs. La majorité des phénomènes compliqués et désordonnés, comme la turbulence ou le climat, possèdent cette propriété. L’importance d’un tel comportement fut reconnue pour la première fois par James Clerk Maxwell dans la seconde moitié du 19ème siècle. Invité à donner une conférence sur le libre arbitre dans son collège de Cambridge, il attira l’attention de ses collègues sur les systèmes dans lesquels une infime incertitude sur leur état présent nous empêche de prédire avec certitude leur état ultérieur. Les équations déterministes ne pourraient s’appliquer que si nous connaissions l’état initial avec une parfaite précision (ce qui ne se peut) : « Il va de soi que l’existence de conditions instables rend impossible la prédiction des événements futurs, si notre connaissance des événements présents n’est qu’approximative et non précise. (...) Que les mêmes antécédents donnent lieu aux mêmes conséquences est une doctrine métaphysique. Personne ne peut le démentir. Mais cela ne sert pas à grand-chose dans un monde comme celui-ci, dans lequel les mêmes antécédents ne se reproduisent jamais, et rien ne se déroule deux fois (...) » John Barrow explique ensuite comment une science des phénomènes chaotiques est issue de ces réflexions, science qui est fort différente de la science habituelle. Le chaos déterministe obéit à des lois, dites non linéaires [1], dans lesquelles le moindre changement d’un des paramètres modifie complètement l’allure des résultats. Connaître la formulation très précise de la loi est impossible. Il faut donc analyser l’ensemble de toutes les lois du même type et en tirer une vision d’ensemble des évolutions possibles. C’est une nouvelle philosophie de la science : « Ces études des équations en général plutôt que des équations en particulier nous ont révélé que le comportement chaotique est la règle plutôt que l’exception. (...) Les phénomènes linéaires, prédictibles et simples, (...) sont les plus faciles à comprendre. (...) Nous pouvons analyser les phénomènes linéaires par parties. Le tout n’est rien d’autre que la somme de ses parties. (...) Les systèmes chaotiques non linéaires diffèrent des précédents. Ils requièrent une connaissance de l’ensemble afin de comprendre les parties parce que le tout est bien plus que simplement la somme des parties. »

« Le souci a été de comprendre pourquoi des systèmes simples et déterministes pouvaient présenter une suite erratique d’états. (...) Le chaos n’est pas un produit ou un matériau dont la technologie pourrait s’emparer pour créer de nouveaux appareils commercialisables (...) Le chaos est avant tout un concept, on pourrait presque dire une « philosophie » des comportements dynamiques. Le chaos déterministe est à la frontière entre l’ordre et le désordre (...) Il est probable que dans ce sens, le chaos représente un mécanisme important d’adaptation et qu’il intervient largement dans le monde du vivant. » exposent les physiciens Pierre Bergé, Yves Pomeau et Monique Dubois-Gance dans « Des rythmes au chaos ».

« De nouveaux concepts scientifiques ont été produits d’une manière souvent transdisciplinaire lors des dernières décennies, sous les termes de « théorie du chaos », « théorie de la complexité », « théorie des systèmes dynamiques non linéaires », etc. (...) Les systèmes dynamiques non linéaires éclairent le concept de bifurcation. Une bifurcation correspond en effet au changement de nature d’un attracteur qui surgit lorsque la valeur d’un paramètre de contrôle du système franchit une valeur critique – ou entre dans un domaine de valeurs critiques. Prenons un cas concret mis en évidence dans certaines réactions chimiques : le système constitué de molécules qui, à l’échelle microscopique – celle des molécules individuelles- réagissent entre elles au hasard de leurs rencontres. Une fois la bifurcation franchie – lorsque la concentration de certains réactifs passe une valeur critique-, les comportements individuels des molécules ne changent pas, mais les conditions sont telles qu’il apparaît dans le récipient qui les contient, un ordre spatio-temporel à l’échelle macroscopique- oscillation des concentrations des réactifs, le milieu restant homogène, ou formation d’inhomogénéités spatiales de concentration en forme de spirales. Le changement d’organisation dans le système dynamique non linéaire est une propriété interne au système : c’est une auto-organisation. Cette bifurcation est donc un phénomène ponctué, critique, par lequel le système acquiert un comportement global nouveau et des propriétés nouvelles. On peut dire qu’une telle bifurcation est un exemple simple d’émergence, analysable, et d’où a disparu toute trace de mystère et de vitalisme. » rajoutent Janine Guespin-Michel et Camille Ripoll dans l’article « La dialectique de l’émergence ». Le physicien Hughes Chaté explique dans la revue « Science et Avenir » d’août 2005 : « Les oscillations collectives ne sont pas structurellement régulières. Elles comportent des fluctuations statistiques qui ne se dissipent que dans la limite du nombre infini de sites. On a donc bien une dynamique chaotique, donnant lieu à un désordre spatio-temporel fort (...) Une collection d’oscillateurs microscopiques bruités, couplés entre eux qui se synchronisent spontanément. On l’aura compris, ces oscillateurs n’ont pas d’existence propre. Ils émergent de la dynamique microscopique et sont présents à toutes les échelles intermédiaires (...) De manière générale, les comportements collectifs émergents de systèmes chaotiques couplés ne sont nullement anecdotiques (...) Ils sont plutôt la règle que l’exception (...) Les comportements collectifs tels que nous les décrivons ici sont bien robustes et donc parfaitement génériques. »

« Aujourd’hui, la physique du chaos est partout : de la cosmologie à la physique de la structure molle, ce ne sont que structures dissipatives, fluides, turbulences, vaguelettes, bulles et tempêtes. » remarque de même le philosophe Pascal Engel dans « L’énigme de l’émergence » dans la revue « Science et Avenir » de juillet 2005. Le physicien-chimiste Ilya Prigogine et la philosophe Isabelle Stengers exposent dans « Entre le temps et l’éternité » les multiples situations pour lesquelles la théorie du chaos déterministe pourraient être la clef de l’énigme. : « Reconnaître parmi les phénomènes qui se présentent comme aléatoires ceux qui pourraient être produits par un attracteur chaotique est évidemment d’une importance majeure. Prenons, par exemple un problème, si crucial aujourd’hui, de l’action de l’homme sur l’environnement. Pour comprendre la portée et la nature de cette action, il est nécessaire d’élucider les modes intrinsèques de comportement de cet environnement. (...) Un système à quatre variables indépendantes pourrait suffire à expliquer l’histoire « chaotique » du climat terrestre. (...) Des séries de données extraites de l’activité du cerveau par électro-encéphalogramme ont également été étudiées. A l’état de sommeil profond, l’activité du cerveau aurait les traits du chaos déterministe et serait caractérisé par un attracteur fractal à cinq variables indépendantes. (...) Au cours de crises d’épilepsie, un attracteur fractal peut à nouveau être repéré, mais dans un espace qui pourrait être défini par deux variables indépendantes seulement. (...) Un électron excité « tombe » vers un niveau inférieur en émettant un photon. (...) La raison du chaos quantique est l’apparition de résonances (...) qui correspondent à des interactions matière/lumière. »

Pourquoi une même théorie, le chaos déterministe, expliquerait-elle des domaines aussi divers que le cerveau et la météo, ou que le vide quantique et le rythme du coeur ? « Comment le cerveau sépare-t-il une odeur de toutes les autres. Comment apprend-il à reconnaître les odeurs familières ? Il semble que ce soit rendu possible par le chaos. (...) Les chercheurs en ont déduit que l’acte de perception consiste en un saut brusque d’un ensemble d’oscillations chaotiques à un autre. Ils pensent que le bulbe olfactif et le cortex entretiennent plusieurs ensembles d’oscillations chaotiques simultanées, une pour chaque odeur familière. » explique le physicien Carlos Calle dans « Supercordes et autres ficelles ». « Depuis 1960, un nombre croissant d’observations conduisent à la conclusion selon laquelle le climat de la terre est susceptible de présenter une variabilité intrinsèque très prononcée. (...) Le système climatique est « porteur « d’une longue histoire des phénomènes complexes de transition. » rapportent les chaoticiens Ilya Prigogine et Grégoire Nicolis dans « A la recherche du complexe ».

L’exemple typique du chaos déterministe est celui du pendule simple mais qui perd de l’énergie par frottement, tout en étant stimulé régulièrement par une source d’énergie. Le mouvement est lent et la stimulation est brutale. Sa durée d’intervention est beaucoup plus courte que le temps caractéristique du pendule. Le résultat est un mouvement apparemment hiératique et pourtant contenant un ordre caché, le chaos déterministe, imprédictible mais obéissant à des lois. La radicalité de l’intervention qui produit l’apport énergétique au mouvement, son caractère ponctué, est cause de cette particularité. C’est la rupture du choc qui produit la non-linéarité à la racine du chaos. Cet exemple simple, le pendule amorti entretenu, n’existe pas dans la nature et pourtant il offre une image considérablement plus riche que le pendule périodique. Car nombre de phénomènes proviennent de deux transformations couplées, l’une beaucoup « étant plus rapide que l’autre. Ainsi, une particule qui perd régulièrement de l’énergie n’en reçoit que par un choc brutal : la réception d’un photon. La matière est sujette, jusque dans ses phénomènes microscopiques, de propriétés chaotiques parce qu’elle ne peut se conserver que grâce à des chocs par lesquels elle gagne de l’énergie. Plus l’énergie en jeu est importante, plus le temps d’intervention doit être court. La discontinuité est brutale et elle fait partie intégrante de l’ordre qui ne peut plus être considéré comme régulier ni périodique.

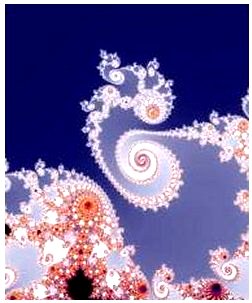

Prenons un exemple tiré de « Dieu joue-t-il aux dés » du mathématicien Ian Stewart, un ouvrage portant sur le chaos déterministe [2] : « La machine à étirer le caramel bouge périodiquement (...) mais le caramel devient chaotique. Une cause régulière : un effet irrégulier. Tous ceux qui utilisent un mélangeur pour pâtes à gâteaux, un batteur d’œufs ou un robot culinaire accomplissent un exercice de dynamique chaotique appliquée. Un appareil mécanique qui bouge d’une manière régulière et prédéterminée mélange les ingrédients de manière aléatoire. Comment cela se fait-il ? ». Ian Stewart répond qu’il y a deux phénomènes : la machine qui mélange et la pâte qui s’étire. Il aurait pu préciser qu’il y a un phénomène rapide et un phénomène lent. Car si la machine fonctionnait aussi lentement que l’étirement, il n’y aurait pas de chaos déterministe [3]. Tout réside donc dans un couplage de deux phénomènes, un lent et un relativement beaucoup plus rapide. Le chaos réside dans l’existence d’un ordre non évident : une forme d’organisation là où il semble exister un désordre. Les physiciens Pierre Bergé et Yves Pomeau expliquent ainsi dans le numéro spécial de « Pour la science » sur le chaos de janvier 1995 : « Même lorsqu’on ne connaît pas les lois de la dynamique, il est possible de distinguer un comportement chaotique d’un comportement purement aléatoire. (...) Un comportement régulier correspond à un diagramme simple, un attracteur. Si le mouvement est aléatoire, les points représentatifs du système remplissent l’espace des phases au hasard : aucune structure n’apparaît. Quand le mouvement est chaotique (au sens d’un chaos déterministe), les points paraissent à première vue aléatoire. Néanmoins, quand on observe le phénomène suffisamment longtemps, on constate que les points dessinent une forme particulière, qui présente une structure feuilletée. A cause de cette géométrie particulière, fractale, ces attracteurs sont qualifiés d’étranges. Ils sont la signature du chaos. »

Chacun a bien conscience que le résultat d’une course hippique est aussi imprédictible que la brisure d’un matériau, le trajet d’une molécule dans un gaz ou d’une poussière dans l’air. On en comprend aisément la raison. Chacun de ces phénomènes obéit bien sûr aux lois de la physique mais le désordre (grand nombre de résultats possibles) est trop important pour prédire. Par contre, quel n’a pas été l’étonnement des physiciens de constater qu’il en allait de même la matière fondamentale, y compris pour une seule particule dans le vide. Imprédictible l’état de la particule, sa position et sa vitesse, le moment où elle va se heurter à une autre particule, émettre ou absorber un photon lumineux. Imprédictible sa trajectoire (position et vitesse). Toutes les transformations brutales présentent le même caractère imprédictible et pourtant elles sont déterministes (obéissent à des lois). L’imprédictibilité n’en est pas la particularité essentielle. « Les séquences historiques des événements sont des exemples classiques de systèmes complexes. Elles montrent une sensibilité à des petits changements qui rend impossible la prédiction du futur avec certitude, même si nous pouvons être en mesure de comprendre ce qui s’est produit par le passé. » écrit le physicien John. D. Barrow dans « Les constantes de la nature ». Pire même si l’on peut dire, des lois simples avec un petit nombre de paramètres peuvent tout à fait posséder la même propriété (sensibilité aux petits changements) appelée aussi sensibilité aux conditions initiales, une des propriétés caractéristiques de ce que l’on appelle le chaos déterministe ou l’imbrication de l’ordre et du désordre.

Si la science tente de comprendre comment la matière, la vie, l’homme et la société ont été produits avec créations successives de nouveauté, elle se hasarde rarement à prévoir les suivantes ! Par exemple, l’expansion a produit un refroidissement producteur des structures matérielles comme la particule, l’atome et la molécule. Mais la physique peut-elle donner une idée des types suivants de structure qui seront produits puisque l’expansion de l’Univers se poursuit et même s’accélère ? Connaître les lois ne suffit pas à prévoir le futur. L’univers se refroidissant a produit la matière et la lumière, les galaxies, les étoiles et les planètes. Qu’y aura-t-il après ? Quelles structures peuvent être issues des nouvelles étapes du refroidissement d’un monde en expansion ? Quelle est la suite de l’évolution de la vie ? Y aura-t-il une autre espèce d’homo après l’homme actuel ? Nul scientifique ne s’aventure d’y répondre. Le type des lois que nous connaissons ne le permet pas. Elles sont divergentes, mènent à des situations où la progression est imprédictible. Et, surtout, elles sont capables de produire des niveaux émergents de structure. Dans ce cas, un changement qualitatif entraîne nécessairement des lois nouvelles qui ne découlent pas directement des précédentes. On peut prévoir la suite dans une série continue de positions ou dans une évolution graduelle, mais pas un changement brutal et qualitatif. La science a longtemps été gênée par l’imprédictibilité souvent assimilée à l’indéterminisme qui est une notion pourtant très différente. L’expression « hasard », employée dans des sens multiples n’a pas clarifié la question. Les débuts de la Mécanique avaient fait croire à une prédictibilité générale en sciences comme le proclamait Laplace. Cela provient du fait que les lois que l’on connaissait jusque là permettaient de prédire : par exemple, la loi du mouvement du boulet. Mais ce n’est pas général. Connaître une loi ne signifie pas nécessairement pouvoir calculer l’état futur à partir de la connaissance des états passés.

Le déterminisme suppose en effet l’obéissance à des lois mais pas nécessairement la capacité de prédire. Et inversement, on peut parfaitement prédire ce que l’on ne comprend pas. Nous ne connaissons pas la nature de la gravitation même si on en connaît la loi mathématique qui nous permet de dire où atterrira un boulet de canon Mais des phénomènes non reproductibles sont-ils du domaine de la science ? Bien des commentateurs affirment que non. Selon eux, la validité des théories est établie uniquement si l’expérience présente des résultats que la théorie avait prédits. Il est vrai que c qui caractérise la démarche de la science, c’est la confrontation permanente entre théorie et expérience mais ce n’est pas une relation à sens unique. Le physicien Werner Heisenberg rappelle dans « La partie et le tout » qu’Einstein répétait volontiers que « Seule la théorie décide de ce que l’on peut observer. » En effet, il faut des concepts et des outils d’analyse pour faire des mesures et, d’autres encore, pour concevoir l’expérience et l’interpréter. Et Heisenberg cite également Wolfgang Pauli, autre spécialiste de la physique quantique : « On peut avoir entièrement compris un certain domaine de la connaissance expérimentale sans pour autant pouvoir prédire exactement les résultats d’expériences futures. » Quand on dit que la science se fonde sur l’expérience, il faut comprendre non seulement ce qui se produit en laboratoire mais aussi et surtout ce que produit la nature. Or la nature n’a parfois produit qu’une seule fois un phénomène, même si on en trouve des multiples reproductions (comme la vie sur terre et ses diverses manifestations). Et on n’a pas nécessairement les moyens de le reproduire ce qui n’empêche pas de raisonner dessus. Même une expérience reproductible ne l’est pas nécessairement à l’identique. Quant aux lois mathématiques, quand elles existent, ne sont pas forcément prédictives. Dans le cas d’une loi « sensible aux conditions initiales », c’est-à-dire être considérablement modifiée par un petit changement initial, tout changement infiniment petit des conditions de départ peut entraîner des divergences qualitatives par la suite. Dans ce cas, on ne peut prédire les suites d’un passé que si on le connaît au plus petit détail près, ce qui est irréalisable. Dans certains cas, une loi peut parfaitement permettre plusieurs « possibles ». C’est le cas pour une bifurcation. Il peut falloir alors une autre loi, à un autre niveau par exemple, pour que la nature tranche. L’ensemble des deux lois ressemble alors à s’y méprendre à du hasard.

En 1889, le mathématicien et physicien Henri Poincaré cherchait à répondre à la question de la stabilité du système solaire. Son mémoire intitulé « sur le problème des trois corps et les équations de la dynamique » remporta le prix du concours ouvert à Stockholm par le roi Oscar II entre les mathématiciens du monde entier, apportant à Poincaré une notoriété internationale. Et c’est dans l’étude du système solaire que l’on a découvert pour la première fois un phénomène chaotique ! En effet, il devait montrer que la gravitation avait beau obéir à des lois, celles-ci engendraient le chaos, cette imbrication d’ordre et de désordre que l’on appelle chaos déterministe. Je rappelle que déterministe signifie un phénomène issu de lois. Poincaré a ainsi montré que certaines lois non linéaires, les lois de l’attraction universelle de Newton en l’occurrence, peuvent engendrer des mouvements chaotiques. Poincaré a également montré qu’un mouvement chaotique peut paraître stable durant quelques dizaines ou centaines de millions d’années avant de quitter la zone de stabilité appelée par lui « un îlot » de stabilité. Et pour cette étude il a considérablement simplifié le problème du système solaire. Il a étudié le mouvement de trois corps. Poincaré a ainsi découvert en étudiant mathématiquement la loi de Newton pour ces trois corps qu’on y trouvait des possibilités nombreuses de mouvements imprédictibles. Etonné et en même temps déçu, il aurait déclaré : « si j’avais su qu’en étudiant les lois de la physique on ne pourrait rien prédire, j’aurais préféré me faire boulanger ou postier que physicien et mathématicien ! »

Mais Poincaré avait rapidement compris que ce n’était pas une faiblesse personnelle qui l’empêchait ainsi de pénétrer le fonctionnement de la nature mais une propriété fondamentale de ce fonctionnement et de sa relation avec l’entendement humain. N’oublions pas que Poincaré, même s’il était un grand scientifique, a plutôt souligné le caractère humain et sensible de l’activité intellectuelle de la science. Je le cite commentant l’activité de la découverte scientifique et expliquant qu’entre deux périodes de travail conscient, il se réalise un travail inconscient. « Le moi inconscient ou, comme on dit, le moi subliminal, joue un rôle capital dans l’invention mathématique […] le moi subliminal n’est nullement inférieur au moi conscient ; il n’est pas purement automatique, il est capable de discernement, il a du tact, de la délicatesse ; il sait choisir, il sait deviner…les phénomènes inconscients privilégiés, ceux qui sont susceptibles de devenir conscients, ce sont ceux qui, directement ou indirectement, affectent le plus profondément notre sensibilité. On peut s’étonner de voir invoquer la sensibilité à propos de démonstrations mathématiques qui, semble-t-il, ne peuvent intéresser que l’intelligence. Ce serait oublier le sentiment de la beauté mathématique, de l’harmonie des nombres et des formes, de l’élégance géométrique. C’est un vrai sentiment esthétique que tous les vrais mathématiciens connaissent. » C’est un passage du chapitre « L’invention mathématique », dans l’ouvrage « Science et méthode » de Poincaré.

Et l’un des résultats de ses travaux sera de relativiser le caractère purement objectif des énoncés scientifiques. Il montre que la science reste une conjecture et non un domaine du certain comme on l’a longtemps cru de façon un peu prétentieuse, à la suite de Laplace. Selon lui, la science est une activité humaine et la relation entre l’homme et la nature reste une recherche sans réponse finale. La meilleure preuve en est que ses propres travaux allaient être rapidement contredits puisqu’il concluait que le système solaire était stable ce que, par la suite, il allait lui-même corriger. Par contre, il a inventé à cette occasion la plupart des méthodes théoriques aujourd’hui appliquées dans un domaine qui n’existait pas à l’époque : l’étude des systèmes dynamiques, autrement appelée chaos déterministe. Il écrit : « Une cause très petite qui nous échappe détermine un effet considérable que nous ne pouvons pas ne pas voir et alors nous disons que cet effet est dû au hasard ». C’est la notion de sensibilité aux conditions initiales.

Dans « Science et méthode », Henri Poincaré explique que l’origine de l’apparence de hasard par le caractère des lois universelles pour lesquelles un petit changement peut produire un grand effet. Du coup, il faudrait connaître tous les détails de la situation, à toutes les échelles, pour prédire : « Si nous connaissions exactement les lois de la nature et la situation de l’univers à l’instant initial, nous pourrions prédire la situation de ce même univers à un instant ultérieur. Mais, lors même que les lois naturelles n’auraient plus de secret pour nous, nous ne pourrons connaître la situation initiale qu’approximativement (...). Il peut arriver que des petites différences dans les conditions initiales en engendrent de très grandes dans les phénomènes finaux ; une petite erreur sur les premières produirait une erreur énorme sur les derniers. La prédiction devient impossible et nous avons le phénomène fortuit. » C’est la notion de « sensibilité aux conditions initiales ».

Poincaré va notamment inventer des méthodes d’étude (espace des phases, section de Poincaré, …) de systèmes pris dans leur ensemble sans étudier les éléments du système pris un par un, méthode particulièrement novatrice. Il va étudier non une seule trajectoire mais l’ensemble des trajectoires possibles et leur relation entre elles. Enfin, il va montrer que les phénomènes physiques sont du domaine de la géométrie et non des formules mathématiques. Je le répète, sa conclusion est qu’avec trois corps interagissant par attraction gravitationnelle on a déjà du chaos c’est-à-dire un phénomène obéissant à la propriété de la sensibilité aux conditions initiales : un tout petit changement de celles-ci peut entraîner un grand changement de la suite de l’évolution. Rappelons que cette thèse révolutionne la conception que l’on avait de la gravitation depuis Newton. Ce dernier pensait que si l’on connaissait précisément les positions et les vitesses de tous les corps célestes on pouvait connaître à tout moment la suite des positions. Poincaré infirme cette thèse. Essayons d’expliquer pourquoi. Je vous rappelle que pour deux corps, du moment que l’on connaît la masse des deux corps et les données de position et de vitesse à l’instant initial on peut calculer les positions des deux corps à tout instant. On connaît en effet une solution analytique qui indique le mouvement et il y a une seule trajectoire possible qui est une ellipse.

On pourrait imaginer que l’on est certain d’avoir une solution puisque l’on connaît les équations du mouvement mais ce n’est pas du tout le cas. La plupart des équations mathématiques non linéaires n’ont pas de solution ou une infinité de solutions.

Une solution analytique est une formule qui indiquera positions et déplacements à tout instant. Les équations ne permettent pas de le dire. Les équations de Newton relient par une formule les diverses dérivées de ces quantités, c’est-à-dire position, vitesse et accélération. Lorsque l’on peut revenir des dérivées aux quantités elles-mêmes on dit que le système d’équations est intégrable mais généralement ce n’est pas le cas. Un exemple bien connu d’intégration est l’équation du mouvement d’un boulet de canon si on connaît la vitesse initiale et l’angle de lancement. Et justement dans le cas du système solaire, en se contentant de trois corps, Poincaré a montré que le système n’est pas intégrable. Il n’y a pas de solution analytique des équations de Newton du mouvement. Poincaré en a même expliqué la raison : il n’y a pas assez d’équations par rapport au nombre d’inconnues. Ce que l’on appelle les inconnues ce sont les positions des corps et leurs variations. Les équations indiquent la conservation d’un certain nombre de quantités qui ne peuvent que s’échanger et non diminuer ou augmenter : l’énergie, la quantité de mouvement et la quantité de rotation.

Il a montré que la multiplicité des trajectoires très proches et imbriquées rend improbable que le système soit intégrable. Les équations ne sont pas assez nombreuses pour en déduire une solution. Il a également montré qu’il en découle une infinité de trajectoires possibles et que l’on n’a aucun moyen de trancher entre elles. En plus la proximité des trajectoires signifie qu’une petite perturbation peut faire sauter le corps d’une trajectoire à une autre imperceptiblement avec du coup un avenir tout à fait différent au bout d’un certain temps. Quelle en est la raison ? Dans le mouvement des trois corps, aucun n’est négligeable. A tout instant la position d’un corps et son mouvement sont modifiés par la position précédente d’un autre corps qui est elle-même modifiée par celle du troisième. C’est ce qui rend impossible les approximations. Impossible par conséquent de dire que tel objet est trop petit pour influencer le système sur le long terme. Impossible de dire que telle modification de distance est négligeable puisqu’elle peut entraîner un changement de trajectoire qui peut être considérable sur le long terme. Impossible même de distinguer l’une des planètes comme un objet indépendant du système. Impossible aussi de distinguer passé et présent. En effet, la position d’une planète dépend de l’ensemble des positions précédentes, de toute l’histoire passée du système. C’est ainsi que, pour prédire, il faudrait connaître avec une précision infinie l’ensemble des conditions précédentes et pas seulement les conditions initiales, c’est-à-dire à un instant donné, du système. Du coup, les trajectoires possibles étant infiniment proches les unes des autres, il suffit d’un petit changement dans les conditions initiales ou d’une petite imprécision pour changer relativement vite l’ensemble de l’histoire de tout le système. Poincaré venait de découvrir le premier domaine d’étude d’un phénomène d’un type nouveau : le chaos déterministe.

Parmi les successeurs des travaux de Poincaré, il convient d’abord de citer Kolmogorov, Arnold et Moser. Ces trois scientifiques vont reprendre le travail de Poincaré et montrer en 1962 dans un théorème appelé KAM de leurs initiales que, dans certaines conditions initiales particulières, il peut y avoir stabilité. Il y a alors des mouvements quasi périodiques et des perturbations suffisamment petites ne peuvent éloigner durablement la planète de sa trajectoire. .

Ils ont donc fait la démonstration que, si les masses et les inclinaisons des ellipses parcourues restent faibles, ces trajectoires restent contraintes à n’évoluer qu’autour d’une espèce de tuyau refermé sur lui-même et appelé le tore. Cette contrainte entraîne une garantie de stabilité, une espèce de garde fou pour le mouvement.

Mais le débat n’était pas achevé pour autant car d’autres physiciens allaient montrer que le théorème KAM s’applique bien à des interactions entre plusieurs corps mais pas au système solaire qui ne satisfait pas aux conditions initiales nécessaires.

Ainsi, en 1998, les savants américains Sussman et Wisdom intègrent le mouvement de Pluton sur un ordinateur et ce mouvement s’avère chaotique. Ils démontrent que ce mouvement obéit à ce que l’on appelle la « sensibilité aux conditions initiales » ou encore la propriété de divergence exponentielle. Exponentielle signifie ici qu’une perturbation au lieu d’additionner ses effets les multiplie et c’est là que réside la source du chaos. En effet, ces deux scientifiques ont calculé que l’incertitude sur les conditions initiales est multipliée par trois tous les 20 millions d’années. Cela signifie qu’en 400 millions d’années, durée sur laquelle on cherche à obtenir une réponse de stabilité, la position de Pluton est complètement imprédictible. L’incertitude est en effet multipliée par trois à la puissance vingt soit 3.486.784.401. Une erreur d’un centimètre se traduit au bout de 400 millions d’années par une modification du résultat de trois milliards et demi de centimètres ! !

Mais c’est surtout dans la foulée des travaux de Jacques Laskar, directeur de recherches au bureau des longitudes de Paris qu’ont été faites les principales découvertes tendant à prouver le caractère chaotique du système solaire. Il a notamment mis en équation le calcul des perturbations qui permet d’extrapoler pour trouver les positions des planètes et il a montré que ce calcul n’était pas valable sur un temps de plusieurs centaines de millions d’années. Les calculs que nous faisons pour positionner les planètes ne sont pas faux mais ils ne sont pas extrapolables pour en déduire la position d’une planète sur une aussi longue durée. La raison ne provient pas d’une erreur ni d’une approximation mais du principe lui-même du calcul. Toute petite approximation entraîne sur un temps aussi long une modification considérable du fait du caractère exponentiel des divergences. Comment ces perturbations peuvent-elles se multiplier ainsi au lieu de simplement s’additionner ? L’explication provient de la rétroaction qui se produit parfois entre deux trajectoires, c’est-à-dire qu’elles ont des fréquences que l’on dit accrochées ou en résonance. Sont en résonance deux phénomènes réguliers dont les périodes sont dans un rapport simple par exemple un sur deux ou trois sur cinq. Dès que deux phénomènes sont dans ce cas, ils interagissent bien plus que la proportion de leur cause. C’est ce qui se produit avec une personne poussant en résonance une balançoire. Cela a pour effet d’accumuler des effets d’entraînement pouvant aller jusqu’au tour complet. Or le rapport entre les périodes des mouvements de Saturne et Jupiter autour du Soleil est exactement dans la fraction 2 sur 5. Cela signifie qu’ils vont se trouver à intervalle régulier dans des positions susceptibles de déformer leurs trajectoires et toujours dans le même sens.

On constate d’autres résonances dans les mouvements planétaires comme la résonance entre les mouvements de précession des orbites de la terre et de Mars, comme la résonance entre les mouvements de précession de Mercure, Vénus et Jupiter. La précession est l’un des paramètres caractérisant le mouvement d’une planète. Du coup, il est difficile de dire si une forte augmentation de l’excentricité du mouvement elliptique d’une planète ne serait pas possible dans un intervalle de cent millions d’années, augmentation pouvant donner une énergie suffisante pour que cette planète sorte du système solaire. L’augmentation de l’excentricité du mouvement elliptique peut causer un choc entre deux planètes comme le montrent les extrapolations de calcul effectuées par Laskar dans une simulation sur ordinateur des équations sur dix milliards d’années. Ce seraient également ces mouvements chaotiques causés par des résonances qui expliqueraient la capacité de certaines trajectoires d’entraîner le corps hors du système, expliquant ainsi les trous dans la ceinture de Kirkwood des astéroïdes (un million de blocs rocheux de moins d’un kilomètre de diamètre qui voyagent entre Jupiter et Mars.)

La résonance signifie le retour régulier d’une interaction brutale. C’est un effet d’entraînement équivalent à l’entretien d’un pendule amorti. On se souvient de l’effet chaotique de cette intervention qui transmet de l’énergie de façon ponctuée au pendule : le mouvement devient chaotique et son avenir est imprédictible. On se souvient par exemple de l’encensoir cité au chapitre « Rétroaction du lent et du rapide » de cette étude. C’est le chaos qui permet de synchroniser les rythmes de la matière, que ce soit les horloges des particules (par le chaos quantique du vide), les circuits électroniques et les lasers (signal électrique entrant chaotique), les oscillations chimiques (comme la glycolyse responsable du principal mode de production d’énergie des cellules vivantes ou les rythmes cardiaques des animaux (chaos causé par la rétroaction des cellules pace-makers du cœur). La raison de cette capacité des messages chaotiques de piloter un système à grande échelle appelée « la maîtrise du chaos » par William Ditto et Louis Pecora, qui écrivent que « Si deux systèmes sont lâchés en opposition de phase, ils le restent pour toujours. (...) En changeant, le signal d’entraînement en un certain type de signal chaotique, deux systèmes peuvent fonctionner en phase. » Cette capacité des résonances au sein du désordre de coordonner les rythmes est une propriété fondamentale du chaos déterministe. Aucune loi non chaotique ne permet à deux ou à un grand nombre de rythmes de s’accrocher ainsi.

Dans toutes les dynamiques produisant des résonances, Poincaré a montré que se retrouvaient des phénomènes du même type (les trajectoires stables sont imbriquées à l’infini dans les trajectoires instables comme dans l’exemple de la dynamique en selle de cheval ou en col) que nous avons appelé « le chaos déterministe ». Dans d’autres domaines que la physique, cette notion allait se révéler productive. La théorie du chaos déterministe a montré d’autre part que des lois peuvent produire des sauts entre des valeurs (discontinuité) et des apparences ressemblant considérablement à du pur hasard. Par exemple, le biologiste Robert May démontrait que, pour certaines valeurs des conditions initiales, une dynamique apparemment régulière autrement, se met à sauter d’une valeur à une autre sans la moindre prédictibilité. Etudiant l’évolution d’une population animale d’une saison à l’autre représentée sous la forme de l’itération d’une suite du type k fois x fois (1-x) et démontrait que, malgré le caractère mathématiquement simple de la fonction, l’itération avec un temps discontinu entraînant une grande complexité des résultats. Et il élargissait ce résultat à d’autres domaines : « Non seulement en recherche, mais aussi dans le monde quotidien de la politique et de l’économie, il serait bénéfique pour tous si plus de gens réalisaient que les systèmes non linéaires simples ne possèdent pas nécessairement des propriétés dynamiques simples. »

Comme l’expose le physicien David Ruelle dans « Où le chaos intervient-il ? », « Le mot chaos fut introduit en 1975 par Jim Jorke, mathématicien à l’Université du Maryland et, vers le milieu des années 1970, le chaos devint une discipline scientifique à part entière. Les nouvelles idées étaient appliquées dans des domaines variés. Robert May, qui travaillait alors au département de zoologie de l’Université de Princeton, montra en 1976 comment le chaos justifie l’existence de fluctuations irrégulières dans les populations animales. En chimie, on savait que certaines réactions étaient oscillantes : je suggérai en 1973 que l’on cherche des oscillations chimiques chaotiques. Plus tard, en effet, on les découvrit et cela a donné, à partir de 1980, à une reconstruction complète de la dynamique des réactions chimiques oscillantes par un groupe de chimistes de l’Université de Bordeaux. Parmi les travaux récents inspirés du chaos, les plus passionnants sont, à mon avis, accomplis en astronomie. Jack Wisdon, de l’Institut de Technologie du Massachussets, Jacques Laskar du Bureau des longitudes de Paris et quelques autres étudièrent, à la lumière de la théorie du chaos, les trajectoires des planètes du système solaire. (...) Il existe en biologie de nombreux phénomènes périodiques d’importance vitale : les rythmes cardiaque, respiratoire, hormonal, entre autres. Il est vraisemblable que la théorie des systèmes dynamiques sera utile pour analyser ces rythmes et quelques résultats appréciables sont déjà apparus, en particulier le travail de Léon Glass à Montréal sur le fonctionnement des cellules cardiaques. » Quelles sont les questions des sciences auxquelles la théorie du chaos offre des approches nouvelles. Je vais en citer quelques unes : l’émergence, l’instabilité dans la stabilité, l’interprétation de la multi-stationnarité (plusieurs états stationnaires possibles avec des sauts de l’un à l’autre), la théorie de la bifurcation (permettant de visionner un changement qualitatif), l’interprétation de l’imprédictibilité de certaines lois non linéaires, etc…

Exposons au travers d’un exemple, celui des cellules de convection, comment le chaos permet d’éclairer un problème important de la science : celui de l’émergence [4]. Grégoire Nicolis, qui a étudié avec Ilya Prigogine le chaos déterministe, expose ainsi le phénomène des rouleaux de convection : « Comment expliquer que le jeu du mouvement désordonné des molécules puisse, dans certaines conditions de non-équilibre, conduire à l’émergence d’un ordre global macroscopique en l’absence de tout contrôle centralisé ? (...) Un exemple concret illustrera notre propos. Imaginons une couche mince d’un fluide limitée par deux plans parallèles horizontaux (...) Imaginons que l’on chauffe le fluide par en dessous. (...) Si l’on écarte progressivement le système de l’équilibre en augmentant la différence de température dT [5], on observe tout à coup pour une valeur critique de dT, une mise en mouvement de la matière. Ce mouvement est loin d’être aléatoire comme c’est le cas du mouvement des molécules individuelles : le fluide est structuré et apparaît sus forme d’une succession de petites « cellules » suivant la direction transverse à celle de la contrainte. Il s’agit du régime de convection thermique ou de Rayleigh-Bénard. On est à présent en droit de parler de propriété émergente (...) qui s’accompagne de la naissance d’une structure dissipative.(...) Au delà de dT, tout se passe comme si chaque élément de volume était à l’affût du comportement de ses voisins, afin d’en tenir compte et de participer au mouvement d’ensemble. (...) Au voisinage d’un point de bifurcation, l’émergence de solutions nouvelles dotées d’auto organisation –telles les cellules de convection de Rayleigh-Bénard- se traduit par des corrélations (...) à l’origine du changement qualitatif des propriétés du système. »

« Les lois de la nature qui sont importantes pour nous émergent par un processus collectif d’auto-organisation (…) « Le tout n’est plus la somme de ses parties » n’est pas seulement une idée, mais aussi un phénomène physique : voilà le message que nous adresse la science physique : voilà le message que nous adresse la science physique. La nature n’est pas uniquement régie par une règle fondamentale microscopique, mais aussi par de puissants principes généraux d’organisation. Si certains de ces principes sont connus, l’immense majorité ne l’est pas. (…) Les éléments fondamentaux de ce message sont formulés dans les très nombreux écrits d’Ilya Prigogine (…) Je suis de plus en plus persuadé que toutes les lois physiques que nous connaissons – pas seulement certaines – sont d’origine collective. La distinction entre lois fondamentales et lois qui en découlent est un mythe, de même que l’idée de maîtriser l’univers par les seules mathématiques. La loi physique ne peut pas être anticipée par la pensée pure, il faut la découvrir expérimentalement, car on ne parvient à contrôler la nature que lorsque la nature le permet, à travers un principe d’organisation. On pourrait baptiser cette thèse « la fin du réductionnisme » (réductionnisme c’est-à-dire le principe « divisons en composantes de plus en plus petites et nous finirons forcément par comprendre »). (…) Puisque le principe d’organisation – ou plus exactement leurs conséquences – peuvent être des lois, celles-ci peuvent elles-mêmes s’organiser en lois nouvelles, et ces dernières en lois encore plus neuves, etc. Les lois du mouvement des électrons engendrent des lois de la thermodynamique et de la chimie, qui engendrent les lois de la cristallisation, qui engendrent les lois de la rigidité et de la plasticité, qui engendrent les lois des sciences de l’ingénieur. Le monde naturel est donc une hiérarchie de descendance interdépendante (…) » écrit le physicien Robert B. Laughlin dans « Un univers différent ».

Dans leur ouvrage « A la recherche du complexe », Grégoire Nicolis et Ilya Prigogine expliquent ainsi l’apparition de comportements collectifs et de structures émergentes : « Une cellule de Bénard simple comporte quelques 1021 molécules. Qu’un nombre aussi énorme de particules puisse adopter un déplacement cohérent en dépit du mouvement thermique aléatoire de chacune d’elles est la manifestation d’une des propriétés essentielles qui caractérise l’émergence du mouvement complexe (...) Cette complexité « organisée » émerge par le jeu réciproque du mouvement thermique désordonné des molécules individuelles et de l’action des contraintes du non-équilibre. (...) La possibilité de décrire à travers ces concepts primordiaux à la fois le comportement des êtres vivants et celui des systèmes physiques, aussi simples soient-ils, marque une avancée essentielle que la Science n’aurait jamais pu prévoir quelques années auparavant. » L’émergence n’est pas un phénomène mystique ni extérieur à la physique, même s’il contredit l’idée de perte inévitable d’ordre qui était celle de la thermodynamique précédente : « L’expérience est parfaitement reproductible puisqu’à partir des mêmes conditions expérimentales on verra toujours apparaître la même structure de convection pour la même valeur du seuil dT (...) La matière est structurée en cellules qui tournent alternativement à droite et à gauche : une fois le sens de rotation établi, celui-ci demeure constamment le même par la suite. Toujours est-il, quelque soit le soin que l’on apporte au contrôle de leur mise en place, deux situations expérimentales qualitativement différentes peuvent apparaître dès que le seuil dT se trouve franchi. (...) Aussitôt que dT excède un peu (dT) seuil, nous savons parfaitement bien que les cellules vont apparaître : ce phénomène revêt un aspect déterministe strict. En revanche, le sens de rotation des cellules ne peut être ni prédit ni contrôlé : seul le hasard sous forme d’une perturbation particulière avait prévalu au moment de l’expérience décidera si une cellule donnée devra tourner à droite ou à gauche. Nous arrivons à une remarquable coopération entre le hasard et le déterminisme. (...) Cette coopération était jusque là limitée en sciences physiques à la seule description quantique des phénomènes se déroulant à l’échelle microscopique. (...) Le fait que, parmi plusieurs choix un seul soit retenu, confère au système une dimension historique, une espèce de « mémoire » d’un événement passé qui s’est produit à un moment critique et qui affectera son évolution ultérieure (...) Pour résumer, nous avons vu que le non-équilibre rendait le système apte à surmonter le désordre (...) et à transformer une fraction de l’énergie reçue de l’environnement en un comportement ordonné d’un nouveau type appelé structure dissipative. Il s’agit d’un régime caractérisé par des ruptures de symétries, des choix multiples et des corrélations à longue portée. »

La convection n’est pas une simple expérience curieuse de laboratoire : elle est à la base de nombreux phénomènes de l’atmosphère comme les vents et les nuages, de phénomènes de déplacement de l’énergie au sein des étoiles ou encore au sein du magma terrestre. Ce qui est caractéristique, c’est que l’on voit apparaître une structure (la cellule de Bénard) qui survient brutalement alors qu’elle n’existait pas auparavant (émergence). La matière a ainsi un grand nombre de phénomènes qui ont été appelés auto-organisation et ont suscité de nombreux travaux dont ceux d’Ilya Prigogine et Stuart Kauffman qui s’attaquent au lien entre propriétés d’auto-organisation de la matière et fonctionnement de la vie et les interprètent comme des effets du chaos déterministe inhérent aux lois de la matière. A la base de ce type de phénomène, l’émergence de structure dissipatives, on trouve deux réactions inverses interactives agissant dans une situation où le non-équilibre est sans cesse entretenu. C’est le cas d’un phénomène chimique qui a une importance déterminante pour le vivant : l’autocatalyse. La catalyse a lieu lorsqu’une réaction chimique à double sens est forcée d’agir dans un sens unique. Le produit de la réaction favorise à nouveau le sens de la réaction qui l’a produit. C’est une rétroaction dite positive. Ce produit est dit autocatalytique puisqu’il favorise sa propre production. La première macromolécule du vivant que nous connaissions et possédant cette propriété est l’ARN qui semble bien être à l’origine de l’ensemble du processus du vivant et de la croissance exponentielle qui le caractérise. « Pour observer les oscillations observées dans un extrait cellulaire, il fallait attendre la découverte du rôle clef de certaines enzymes dans ces chaînes de réactions qui, grâce à leurs propriétés « allostériques » régulent le débit de la chaîne de réactions. Concept développé par Jacob, Monod et Changeux à Paris et par Arthur Pardee aux Etats-Unis, il s’agit de la régulation d’une chaîne de production biochimique par la rétroaction d’un des produits de cette réaction sur un catalyseur situé au début de la chaîne. (...) Le plus souvent, les produits d’une réaction inhibent l’enzyme allostérique qui régule le débit de la chaîne métabolique (...) Dès que la quantité du produit final baisse, la chaîne de production peut redémarrer (...). Ce type de coopérativité entre site catalytique et site régulateur joue un rôle important dans la coordination de nombreuses réactions métaboliques dans la cellule. (...) Les calculs théoriques de Goldbeter permettent de représenter les oscillations entretenues du système (...) En variant la concentration du substrat, le système évolue vers un cycle limite. (...) Ce formalisme dit du « chaos déterministe » est en effet applicable à de nombreuses réactions biologiques. (...) La « constance » des paramètres physiologiques, concept central du fonctionnement normal de l’organisme, n’est qu’apparente. Les paramètres physiologiques ou biocliniques que l’on peut enregistrer avec une précision suffisante oscillent autour d’une valeur moyenne et ses oscillations obéissent aux lois de la théorie du chaos. » rapporte le biochimiste Ladislas Robert dans « Les temps de la vie ».

« Comment l’organisation de la matière a-t-elle pu évoluer spontanément vers des niveaux supérieurs ? En d’autres termes, comment le chaos peut-il engendrer des systèmes ordonnés. (...) De telles structures accédant spontanément à un degré supérieur sont appelées par Prigogine « structures dissipatives », puisqu’elles produisent et dissipent dans l’environnement un excès d’entropie. (...) Loin de l’équilibre, la dissipation d’énergie devient source d’ordre. » s’interroge le chimiste Martin Olomucki dans « La chimie du vivant ». « Rien n’interdit – et c’est ce qui semble se confirmer – que les modalités de passage du simple au complexe, ou du microscopique au macroscopique, obéissant à des lois indépendantes du niveau de complexité. Une véritable branche autonome de la physique s’est constituée, relativement récemment, qui se fixe comme objectif l’étude du passage du simple au complexe. Il s’agit de la physique statistique, prolongement de la thermodynamique, qui s’intéresse aux transitions de phases, aux phénomènes critiques, aux processus irréversibles et chaotiques, aux systèmes dynamiques, aux structures dissipatives, etc… ». réfléchit le physicien Gilles Cohen-Tannoudji dans « La Matière-Espace-Temps ».

Doit-on expliquer les phénomènes du vivant comme ceux de la physique par le chaos déterministe, comme l’a fait Stuart Kauffman ? On ne peut qu’être impressionnés par les derniers progrès de la génétique mais, me direz-vous, quel est le rapport avec la théorie du chaos déterministe qui a obtenu des succès en mathématiques et en physique ? Faut-il chercher à l’étendre au coeur, au cerveau, et ensuite, vouloir encore interpréter ainsi l’évolution des espèces ? Est-ce que cela ne ressemble pas à la poudre de perlimpinpin qui prétend soigner aussi bien les rhumatismes que les boutons sur les fesses ? Et ne vaudrait-il pas mieux maintenir le chaos déterministe dans les domaines des mathématiques et de la physique, au lieu de vouloir l’appliquer au vivant ? Ne vaudrait-il pas mieux laisser la génétique et la biologie à leurs spécialistes, sans chercher à expliquer des phénomènes de ces domaines par une théorie extérieure ou par une théorie fourre-tout ?

Avant de répondre à ces questions légitimes, il convient de rectifier une interprétation erronée de la thèse du chaos déterministe, interprétation parfois favorisée par la presse à sensation, plutôt que par les scientifiques eux-mêmes et selon laquelle la théorie du chaos prétendrait non seulement englober mais uniformiser tous les domaines des sciences. En fait, cette théorie n’affirme pas que la météorologie et le coeur sont des parties d’un même phénomène, mais seulement qu’ils ont un même type de dynamique. La théorie du chaos n’est pas un domaine d’étude comme l’électricité ou la gravitation. Le chaos n’est pas un objet physique comme l’électron, le ballon ou l’onde. « Chaotique » est un qualificatif qui décrit le type de dynamique d’un système, un qualificatif du même genre que des expressions comme instable, agité, ou linéaire. Employer ce qualificatif pour des phénomènes divers ne signifie pas prétendre qu’ils ont un rapport réel, matériel, entre eux. De même, lorsqu’on parle de pendule périodique, de mouvement périodique du ressort et d’oscillation périodique pour l’électricité, il ne s’agit pas de prétendre que ce sont des phénomènes identiques. Le terme de chaos déterministe caractérise le type de rythme. L’intérêt est que l’on dispose pour décrire le phénomène chaotique d’outils mathématiques (modes de calculs, courbes, mesures de dimensions), de types d’attitudes, de raisonnements, de méthodes et de concepts spécifiquement adaptés à ce type de dynamique.

Le chaos déterministe est une démarche opposée à celle, classique, qui considère qu’ordre et désordre sont diamétralement opposés : ou du désordre ou des lois. La théorie du chaos considère, au contraire, que les deux coexistent et qu’un certain désordre peut servir à stabiliser un certain type d’ordre. Ce n’est pas simplement une autre mathématique mais un nouveau paradigme. J’en donne un exemple : dans la formation d’un solide, plus les molécules qui se déposent sont agitées plus elles vont remplir méthodiquement les cases de la structure : plus il y a de désordre, plus cela produit finalement d’ordre. C’est ce que l’on appelle la théorie des tas d’oranges. L’empilement le plus précis se produit quand les oranges sont distribuées le plus au hasard. Là où la méthode classique oppose ordre et hasard, la théorie du chaos voit une situation à la limite de l’ordre et du désordre, une dynamique se fondant sur des fluctuations mais avec tout de même des lois. La météorologie peut être décrite par des fonctions simples et modélisables par des courbes appelées attracteurs de Lorenz, alors que chacun sait qu’il y a du désordre dans la météo. La théorie du chaos offre des méthodes pour trouver des courbes, effectuer des mesures. Elle permet de trouver des attracteurs. Avec des équations simples comme celle de Lorenz, on retrouve le type de dynamique réelle qui ne nécessite donc pas un très grand nombre de paramètres, contrairement à ce que l’on croyait. Le chaos établit un déterminisme, une relation causale impliquant le phénomène dans sa globalité et dans les interactions entre les éléments, plutôt que de l’interpréter comme la somme de ses éléments. Le chaos s’oppose toujours au réductionnisme car la somme des causes peut entraîner un effet qui dépasse la somme des effets.

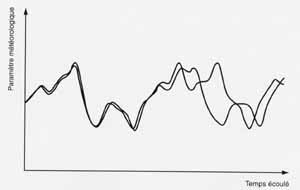

Le chaos déterministe n’a pas le sens qui est donné au mot chaos dans le langage courant où il signifie simplement agitation ou désordre ; il convient de distinguer entre chaos et pur hasard. Alors que pour le hasard il n’y a aucune relation entre deux valeurs successives, le chaos déterministe suppose, au contraire, qu’il y a une relation. Le terme déterministe souligne justement que, même si on est dans une situation où on trouve du désordre, il y a une loi cachée. Comment comprendre ce paradoxe : un système est décrit par une loi et pourtant les paramètres qui obéissent à cette loi sont désordonnés. Cela est dû à une propriété fondamentale de ce type de loi : l’effet multiplicateur ou accroissement exponentiel d’une petite variation de départ. C’est ce que l’on appelle l’ « effet papillon », « l’effet boule de neige », « l’effet de pointe », « l’effet d’avalanche » ou, en termes moins imagés, la sensibilité aux conditions initiales. Deux points de départ très proches l’un de l’autre mènent rapidement à des situations complètement divergentes, comme dans le schéma d’une évolution météorologique. Comme le suggère l’expression effet boule de neige, il y a une croissance multiplicative. Plus la boule est déjà grosse plus elle grossit. Donc la croissance entraîne la croissance et du coup une petite cause peut entraîner un grand effet, si grand même que l’effet peut atteindre un niveau hiérarchique plus élevé. Ce type de situation est beaucoup plus courant qu’il n’y parait et a des propriétés très spéciales. Et d’abord une conséquence négative : bien que le système obéisse à une loi, il n’y a pas prédictibilité. Mais cela a aussi une conséquence extrêmement intéressante : il s’agit de systèmes déterministes qui produisent de la nouveauté, de nouvelles structures, un nouveau mode d’organisation qui n’étaient pas inscrits dans les règles de départ.

Comme tous les phénomènes chaotiques, la météo terrestre est capable de brutales innovations. Le dernier ouragan nous l’a montré et des tempêtes ont bien des fois été une surprise. Inutile donc de chercher à prédire à partir des lois chaotiques de la météo. Si ces lois disent une chose, c’est bien que la météo n’est pas prédictible à long terme ! Mais cela ne signifie pas qu’il s’agit seulement de désordre. Il y a de l’ordre aussi dans la météo. Les types de climats sont durables et l’histoire des climats terrestres montre qu’ils changent brutalement au bout de quelques millions d’années. Cela signifie qu’un certain équilibre entre les masses d’air dans l’ensemble planétaire peut changer et se modifier, non sur quelques jours mais pour des durées considérables. On conçoit que produire de la nouveauté soit une propriété qui nous intéresse quand il s’agit de comprendre comment de nouvelles espèces peuvent naître ! Rappelons que rien de neuf n’apparaît dans un système périodique ou linéaire. Quand on le perturbe, faiblement ou fortement, tout au plus du désordre peut succéder à l’ordre très régulier. Au contraire, le chaos possède une capacité de s’organiser spontanément à de nombreux niveaux, ce qui a un grand intérêt pour modéliser et comprendre le vivant.

Dans des phénomènes dynamiques qui s’appuient sur des variables présentant un désordre permanent, pour voir se former un ordre extraordinairement structuré il n’y a pas besoin d’une loi complexe. Il suffit d’une loi non linéaire, même une loi très simple, et d’au moins trois paramètres. Et cette propriété est très courante dans la matière, comme dans le processus de la vie. C’est même la linéarité qui est un cas plutôt rare dans la nature. Une loi linéaire est fondée sur la proportionnalité entre des facteurs et est représentée graphiquement par une ligne droite. Elle est prédictible car les effets sont proportionnés aux causes. Une telle loi ne donne pour chaque condition initiale qu’une seule solution possible contrairement à la grande variété de solutions avec saut d’une solution à l’autre dans une fonction chaotique. Un phénomène linéaire peut se maintenir ou être détruit mais pas se modifier. Dans un premier temps la science a exploité toutes les possibilités d’expliquer les phénomènes par des linéarités pour la seule raison que, dans ce cas, on était capable de résoudre les équations. Mais cela a créé l’illusion qu’une croissance linéaire était quelque chose de naturel alors, qu’au contraire, c’est plutôt exceptionnel. Ilya Prigogine a étudié des structures qu’il appelle dissipatives qui exhibent une croissance non linéaire. Comme l’expose le philosophe des sciences Alain Boutot, « Les structures dissipatives ne peuvent apparaître que dans les systèmes satisfaisants à deux conditions bien précises : ils doivent être ouverts aux flux de matière et d’énergie qui les traversent d’une part et maintenus loin de l’équilibre thermodynamique d’autre part. (...) Lorsque les systèmes sont maintenus loin de l’équilibre thermodynamique, leur comportement est tout autre. L’explication physique de cette différence est que le théorème du minimum de la production d’entropie n’est plus vérifié. » Or, la possibilité de trouver des équations linéaires est liée à un système à l’équilibre ou situé non loin de l’équilibre, comme le formule Ilya Prigogine. : « Les équations loin de l’équilibre sont non linéaires. Près de l’équilibre on peut linéariser ; il y a alors une seule solution ; loin de l’équilibre, vous avez beaucoup de solutions et c’est cela qui conduit à l’idée d’auto-organisation. L’idée d’auto-organisation, c’est que le système, par suite de son histoire, se meut suivant des chemins différents traversant des états différents. (...) Les phénomènes irréversibles, loin d’être simplement des apparences ou des choses triviales, comme le chemin vers le désordre, ont au contraire un rôle constructif extraordinaire. (...) On a découvert que quand vous allez loin de l’équilibre, par exemple en considérant une réaction chimique que vous empêchez d’arriver à l’équilibre, se produisent des phénomènes extraordinaires que personne n’aurait cru possibles, par exemple des horloges chimiques. (...) Loin de l’équilibre, dans d’importantes classes de réactions chimiques se produisent des phénomènes rythmiques. Cela signifie qu’une cohérence naît et qui n’existe que loin de l’équilibre. (...) Un être vivant est un ensemble de rythmes, tels le rythme cardiaque, le rythme hormonal, le rythme des ondes cérébrales, de la division cellulaire, etc. Tous ces rythmes ne sont possibles que parce que l’être vivant est loin de l’équilibre. Le non-équilibre, ce n’est pas du tout les tasses qui se cassent ; le non-équilibre, c’est la voie la plus extraordinaire que la nature ait inventé pour coordonner les phénomènes, pour rendre des phénomènes complexes possibles. » analyse Ilya Prigogine dans « Temps à devenir ».

La non-linéarité d’un phénomène signifie qu’il est descriptible par une loi qui n’est ni additive ni fondée sur une proportionnalité. La somme des causes n’entraîne pas nécessairement la somme des effets. Le double d’une cause peut être différent du double de l’effet. Les systèmes non linéaires sont dynamiques, fondés sur des contradictions et sur des interactions d’échelle (un phénomène à une échelle a une influence à une échelle différente). Une petite transformation quantitative provoque un changement qualitatif. La linéarité n’est une approximation valable des lois naturelles que dans de rares cas particuliers. Même le « simple » pendule est non linéaire ! Dans « Les mathématiques de l’évolution », conférence de juillet 2002 pour l’Université de tous les savoirs, le mathématicien Régis Ferrière expliquait que « Les relations entre les variables d’un système biologique sont typiquement non linéaires – les effets ne sont pas proportionnels aux causes (...) » L’importance que la science a longtemps accordé au linéaire provient de la facilité de l’étudier mathématiquement et d’en déduire une prédiction. La plupart des auteurs ont retenu que le non linéaire donnait de l’imprédictibilité mais l’essentiel est ailleurs : passé un seuil, ces lois mènent à une discontinuité et à un domaine nouveau. Et la non-prédictibilité ne signifie pas qu’il n’y a pas de loi ni que la nature agit « librement ». La particularité essentielle du non linéaire est sa capacité spontanée de création de nouveauté. La non-linéarité est synonyme d’émergence de l’ordre. » Le paléontologue Stephen Jay Gould écrit ainsi dans « Le renard et le hérisson » : « Les propriétés qui apparaissent dans un système complexe sous l’effet des interactions non linéaires de ses composants sont dites émergentes – puisqu’elles n’apparaissent pas à un autre niveau et ne sont révélées qu’à ce niveau de complexité. (...) L’émergence n’est donc pas un principe mystique ou anti-scientifique, ni une notion susceptible d’avoir des échos dans le champ religieux (...) C’est une affirmation scientifique sur la nature des systèmes complexes. »

Dans une transformation linéaire, l’effet est double quand la cause est double et l’addition des causes provoque l’addition des effets. « Les problèmes linéaires sont faciles. Ce sont des problèmes dans lesquels la somme ou la différence de deux solutions est aussi solution. (...) Les phénomènes linéaires se prêtent à une modélisation mathématique très précise. Le résultat d’une opération linéaire varie continûment et de manière douce en fonction de tout changement des données initiales. Dans le cas des problèmes non linéaires, au contraire, les erreurs s’amplifient si rapidement qu’une incertitude infinitésimale dans l’état présent d’un système rend vaine toute prédiction de son état au delà d’un court laps de temps. (...) Les professeurs exhibent les solutions des équations linéaires et les manuels donnent la préséance à l ‘étude des phénomènes linéaires car ce sont les seuls exemples qui puissent être résolus facilement. (...) En revanche l’équation non linéaire la plus simple que l’on puisse imaginer exhibe un comportement d’une profondeur et d’une subtilité insoupçonnée qui, en pratique, est complètement imprédictible. » rappelle John Barrow dans « La grande théorie ». « Bien que le chaos soit déterministe, il est imprédictible » écrivent William Ditto et Louis Pecora dans l’article « La maîtrise du chaos ». Et Christian Vidal, rapportant les expériences chimiques chaotiques, expose dans son article « Le chaos déterministe en chimie « L’évolution chaotique obtenue est décrite par les mêmes équations que le comportement périodique observé auparavant, dans des conditions voisines. (...) La structure de l’attracteur implique que partant de deux points (extrêmement proches), le comportement ultérieur du système peut être très différent. ». Citons quelques exemples de phénomènes non linéaires : le pendule amorti entretenu, la boussole entre deux champs magnétiques, l’effet papillon de la météorologie, le rythme du système cardiaque, des réactions chimiques comme celle de Belouzov ou biochimiques rétroactives (la glycolyse), etc… L’exemple le plus frappant du non linéaire est la biologie et l’évolution du vivant. L’a priori du linéaire a, là aussi, causé bien des erreurs. On a vu dans la relation un gène / une protéine produite une fabrication en chaîne directe de l’être, directement programmée par l’écriture de l’ADN. C’est faux. En réalité, l’apparence continue de la molécule d’ADN est rompue par la présence d’éléments non codants, les introns, qui s’intercalent parmi les éléments codants. Elle contient aussi des éléments de régulation qui rétroagissent sur les gènes, les éléments de régulation. Elle est modifiée par ce qu’Housset et Raisonnier appellent « la discontinuité des gènes » dans « Biologie moléculaire ». La non-linéarité concerne le fonctionnement mais aussi l’évolution du vivant. Ainsi, la paléontologue Brigitte Senut expose dans « Grands singes-hommes : histoire d’une divergence » pour l’Université de tous les savoirs de juillet 2003 que « La divergence entre les grands singes et l’homme est un des sujets les plus discutés de la paléontologie humaine, probablement parce qu’il touche directement à nos origines. (...) En fait, les chercheurs dans leur grande majorité ont focalisé leurs travaux sur les australopithèques, et toute pièce hominidée trouvée dans des niveaux plus anciens était systématiquement considérée comme un ancêtre de ceux-ci, et donc des hommes. L’évolution était considérée comme linéaire, ce qui malheureusement ne semble pas très biologique. »

On a longtemps cru que la relation synonyme de science s’exprimait : « les mêmes causes produisent les mêmes effets ». En fait, elle a surtout permis de soutenir une vision finaliste de la nature. La relation en question est souvent exprimée comme si la cause agissait pour réaliser tel effet. Or jamais on ne dispose de la moindre preuve d’une telle intentionnalité dans la nature. Aucune cause ne produit un seul effet. Aucun effet n’est le résultat d’une seule cause. Les oiseaux n’ont pas des ailes pour voler ni les planètes n’ont une masse pour tourner au tour du soleil. Dans un mouvement comme celui des planètes, il est impossible d’isoler une seule relation de cause à effet entre la planète et le soleil. « Tout se passe comme si » le soleil attirait la planète mais rien ne se passe véritablement ainsi. Remarquons à cette occasion que les « mêmes causes » ne sont pas reproductibles dans la plupart des phénomènes, en particulier dans tous ceux dits « sensibles aux conditions initiales ». Dans ce cas, une même cause nécessiterait l’identité complète des paramètres et est donc invérifiable expérimentalement.

La non-linéarité met en parallèle les propriétés des deux types de fonctions. Une fonction non linéaire peut provoquer l’amplification de toutes petites mutations ; elle peut les stabiliser et fonder des structures stables. Du coup, ordre et désordre, loin d’être contradictoires, ne sont que les deux faces de la même propriété de non-linéarité. Des mathématiciens comme Poincaré, Kolmogorov ou Smale ont démontré que, pour un phénomène comprenant au moins trois variables, la non-linéarité implique le chaos déterministe.

La théorie du chaos déterministe est une révolution conceptuelle de la science. C’est ce nouveau point de vue qu’il est fondamental de comprendre. En ce qui concerne la dynamique, il y a toujours eu en sciences deux démarches opposées. La première consiste à supposer que les effets sont proportionnels aux causes, que l’immobilité est plus naturelle que le mouvement, que ce dernier provient de l’action extérieure sur le système plutôt que de l’évolution interne et qu’un système laissé à lui-même aura spontanément tendance à aller vers la stabilité. La deuxième démarche, celle du chaos, considère que l’agitation aléatoire est la plus fréquente dans la nature mais que celle-ci toutefois peut être à la base de structures dynamiques mais durables. Jusque là on croyait que lorsqu’un phénomène obéit à une loi, l’ordre et le désordre, la stabilité et l’instabilité, la continuité et la discontinuité s’opposaient nécessairement. Cette manière de voir est remise en question. Elle ne convenait que parce que l’on ne traitait que des phénomènes impliquant une ou deux variables du fait de la difficulté des calculs comportant trois variables et plus. Or il s’avère qu’à partir de trois variables, on peut avoir un état dynamique durable fondé sur une instabilité sous-jacente. Durable ne veut pas du tout dire stable. Dans la stabilité, il y a un attracteur vers une position unique. Dans la durabilité, il y a une dynamique interne qui permet de conserver des propriétés globales, dynamique fondée justement sur l’éloignement d’une position d’équilibre. Les exemples sont légion : nuage, flocon de neige, bulle, goutte, surface de liquide, séparation entre deux milieux, particule, cellule vivante, ville sont des structures durables et loin de la constance. A l’intérieur, l’agitation est permanente. Les éléments de la structure eux-mêmes ne sont pas fixes mais s’échangent.

L’ancienne conception de la stabilité signifiait que le mouvement diminue de plus en plus pour finir par s’arrêter. Mais, au contraire, les états globalement stables qu’étudie le chaos sont dynamiques, c’est-à-dire continuellement en changement et en mouvement. Les variables ne vont pas vers l’immobilité. La stabilité, qui n’est que globale et non locale, correspond au fait que dans une zone le nombre de variables, évoluant de manière indépendante, diminue. Ce nombre, appelé degré de liberté du système, indique combien de variables sont nécessaires pour décrire le phénomène. Ces variables peuvent évoluer de manière aléatoire mais l’ensemble du phénomène reste longtemps dans ces zones où le degré de liberté est moindre. Cette stabilité globale d’une zone n’empêche pas les mouvements ni les changements et, au bout d’un certain temps, le passage d’une zone à une autre, d’un ordre à un autre. Il y a à la fois agitation et constitution de structures avec possibilité de plusieurs niveaux de structure. Il est même possible que l’on ait stabilité à un niveau, en même temps qu’instabilité à un autre ou encore continuité à un niveau et discontinuité à un autre : on est à la frontière de l’ordre et du désordre. C’est ce type de phénomène qui explique que la matière passe brutalement de l’état solide à l’état liquide puis à l’état gazeux. Le désordre sous-jacent qui permet ces divers modes d’organisation est le mouvement des molécules.

Cette agitation moléculaire, appelée mouvement brownien, est un exemple classique de phénomène chaotique. Les molécules s’agitent en tous sens et, en se cognant entre elles, établissent dans un récipient un certain niveau moyen d’agitation au bout d’un certain temps, ce qui détermine une température stable. On sait que ce mouvement permet plusieurs niveaux d’organisation comme gaz, liquide et solide avec un saut qualitatif de l’un à l’autre. L’ordre liquide obéit à certaines lois et ces lois changent brutalement et radicalement en passant à l’ordre gazeux. C’est une transition de phase et un saut qualitatif. La matière s’organise d’elle-même, du fait de ses propres lois. Même si une intervention extérieure peut permettre de sauter d’un état à un autre, ce n’est pas cette action externe qui définit le nouvel état. Le passage d’un ordre à un autre peut dépendre de la contingence des forces extérieures et dépendent toujours de la contingence des chocs moléculaires, mais il est cependant fondé sur les lois de la thermodynamique. Comme on le voit, obéir à une loi n’est pas incompatible avec être fondé sur du désordre et du hasard : en mathématiques, on parle de fonction de variables aléatoires.

Comment Stuart Kauffman a-t-il mis en relation chaos déterministe et fonctionnement du vivant ? Il remarque que les gènes n’ont pas une action linéaire mais, au contraire, sont sans cesse fondés sur des rétroactions. Il y a bien dans le vivant un mécanisme d’itération, à la fois positive et négative. L’itération positive est expansive, c’est-à-dire qu’elle a tendance multiplicative à amplifier sans cesse ses effets. Mais cette tendance n’est actionnée que si une inhibition est elle-même inhibée. On trouve de multiples interactions de ce type dans les réactions enzymatiques [6]. Il en résulte un ordre qui est multi-stationnaire. C’est d’autre part un ordre sensible aux conditions initiales.

Le physicien Bernard Derrida expose, dans « La complexité, vertiges et promesses », les remarques profondes de Stuart Kauffman sur le fonctionnement du vivant : « Il était parti de l’idée que toutes les cellules d’un individu ont le même patrimoine génétique (la même molécule d’ADN), sans pour autant être identiques : il existe de nombreuses cellules différentes – les cellules du foie, les cellules cardiaques, les neurones, etc… - et on cherche à expliquer l’origine de cette diversité. Les mêmes gènes sont présents dans toutes les cellules mais, dans une cellule donnée, certains gènes s’expriment et d’autres non. Dans le modèle proposé par Stuart Kauffman, les différents types cellulaires apparaissent comme les différents attracteurs d’un réseau d’automates booléens (automates connectés de façon aléatoire qui génèrent des comportements collectifs particuliers). En faisant varier certains paramètres, il avait constaté que le système passait d’un comportement chaotique à un comportement régulier. »

« De la compréhension que l’on a de la vie découle une autre compréhension de l’homme. En passant d’une conception linéaire et hiérarchique de l’arbre du vivant au buisson en éventail de la diversité des formes de vie, on retrouve l’homme et sa lignée dans une position très différente, au bout d’une petite branche (...) » écrit Pascal Picq en préface à « Petit traité de l’évolution » de Ian Tattersall où l’auteur et paléoanthropologue écrit : « Dans les années 60, tout le monde considérait comme allant de soi que l’évolution de l’homme n’était qu’un long cheminement obstiné menant de l’état primitif à la perfection. Selon cette vision dominante, excessivement linéaire, Australopithecus avait donné Homo Erectus, lequel avait donné Homo Sapiens, grâce à l’intervention toujours bienveillante de la sélection naturelle. » L’histoire d’une interaction dialectique est non linéaire car elle est antagonique. Il y a rétroaction des causes et des effets. Les causes deviennent des effets. Les effets contrôlent les causes, les modifient, les inhibent. Il y a redondance des causes. Les causes sont en arborescence, de même que les effets… Le chaos déterministe intègre la contradiction dialectique ordre/désordre, hasard/nécessité et conservation/transformation. Dans les multiples domaines divers où il trouve un sens, le chaos déterministe est une nouvelle vision de la dynamique contradictoire au sens dialectique, une véritable redécouverte de la dialectique par des scientifiques qui en ignoraient jusqu’à l’existence. En effet, cette nouvelle science retrouve trois phénomènes qui caractérisent la dialectique : le tout n’est pas la somme des parties (appelé sensibilité aux conditions initiales), l’interpénétration des contraires produisant le saut qualitatif, et la construction de structures dynamiques complexes (attracteur étrange).

Extraits de "Entre le temps et l’éternité" de Prigogine et Stengers :

"La raison du chaos quantique est l’apparition des résonances. (...) Ces résonances, qui caractérisent l’ensemble des situations fondamentales de la mécanique quantique, correspondent à des interactions entre champs (c’est-à-dire aussi aux interactions matière-lumière). On peut affirmer que notre accès au monde quantique a pour condition l’existence des systèmes chaotiques quantiques. (...)